تصور کن وارد اتاقی میشوی که تازه مرتب شده است. همهچیز سر جای خودش قرار دارد. چند ساعت بعد، بدون آنکه کسی عمداً بینظمی ایجاد کرده باشد، کتابی جابهجا شده، لیوانی روی میز مانده، کاغذی تا خورده است. این تغییر آرام، نامحسوس و اجتنابناپذیر است. آنتروپی (Entropy) دقیقاً از همین جنس تغییر سخن میگوید. نه از آشوب ناگهانی، بلکه از تمایل طبیعی جهان به حرکت از نظم به پراکندگی.

آنتروپی فقط یک اصطلاح فیزیکی نیست. این مفهوم در زندگی روزمره، در فناوری، در زیستشناسی، در ذهن انسان و حتی در ساختار اطلاعات حضور دارد. وقتی فایلها روی یک سیستم رها میشوند، وقتی حافظه انسانی جزئیات را فراموش میکند، وقتی انرژی مفید به گرما تبدیل میشود، رد پای آنتروپی دیده میشود. این واژه، پلی است میان تجربهی زیسته و قانونهای بنیادی طبیعت.

شاید عجیب باشد که مفهومی به این اندازه انتزاعی، اینقدر ملموس عمل میکند. ما بیآنکه نامش را بدانیم، هر روز با آن زندگی میکنیم. از خنک شدن قهوهای که روی میز置 مانده تا شلوغ شدن یک شهر، از تحلیل رفتن تمرکز ذهنی تا فرسایش ابزارها، همگی روایتهای مختلفی از یک روند مشترکاند.

آنتروپی به ما یادآوری میکند که بینظمی دشمن پنهان نظم نیست، بلکه ادامهی منطقی آن است. جهانی که حرکت دارد، تغییر میکند. جهانی که تغییر میکند، ناگزیر به سوی حالتهای محتملتر میرود. فهم آنتروپی یعنی دیدن این حرکت، بدون اغراق و بدون ترس. شاید همین درک، نگاه ما را به طبیعت، فناوری و حتی زندگی شخصی، دقیقتر و واقعبینانهتر کند.

۱- ریشهٔ واژهٔ آنتروپی و معنای پایهای آن در دانش

واژهٔ آنتروپی از ریشهٔ یونانی «انتروپیا» گرفته شده است که به معنای دگرگونی، چرخش درونی یا تغییر حالت است. این انتخاب واژگانی تصادفی نبود. فیزیکدانان قرن نوزدهم به مفهومی نیاز داشتند که نه صرفاً حرکت، بلکه جهتِ تغییر را توضیح دهد. آنتروپی دقیقاً همین نقش را ایفا کرد. مفهومی که نشان میدهد تغییرها تصادفی نیستند، بلکه گرایشی مشخص دارند.

در فیزیک کلاسیک، آنتروپی به عنوان معیاری برای سنجش میزان پراکندگی انرژی معرفی شد. انرژی میتواند وجود داشته باشد، اما همیشه به شکل مفید در دسترس نیست. وقتی انرژی از حالتی متمرکز به حالتی پخششده تبدیل میشود، آنتروپی افزایش مییابد. این تعریف ساده، پایهٔ فهم بسیاری از پدیدههای طبیعی شد.

نکتهٔ مهم این است که آنتروپی الزاماً به معنای بینظمیِ ظاهری نیست. گاهی یک سیستم میتواند از نظر ظاهری منظمتر شود، اما آنتروپی کلی آن افزایش یابد. این تمایز، سوءبرداشت رایج دربارهٔ آنتروپی را اصلاح میکند. آنتروپی بیشتر با «تعداد حالتهای ممکن» سر و کار دارد تا با شلوغی قابل مشاهده.

در علوم مختلف، این تعریف پایهای گسترش یافت. در شیمی، آنتروپی به رفتار مولکولها (Molecules) و آرایشهای ممکن آنها مربوط شد. در فیزیک آماری (Statistical Physics)، آنتروپی به شمار حالتهای ریزمقیاس (Microstates) پیوند خورد. هرچه حالتهای ممکن بیشتر باشد، آنتروپی بالاتر است. این نگاه، آنتروپی را از یک مفهوم کیفی به ابزاری تحلیلی تبدیل کرد.

۲- قانون دوم ترمودینامیک و جهتدار بودن جهان

آنتروپی بدون قانون دوم ترمودینامیک (Second Law of Thermodynamics) معنای کامل پیدا نمیکند. این قانون میگوید در یک سیستم بسته، آنتروپی هرگز بهطور خودبهخودی کاهش نمییابد. یا ثابت میماند، یا افزایش پیدا میکند. همین گزارهٔ ساده، یکی از عمیقترین پیامدهای علمی را در خود دارد. جهان جهت دارد.

پیش از این قانون، قوانین فیزیکی بیشتر متقارن به نظر میرسیدند. حرکتها میتوانستند به جلو یا عقب تصور شوند. اما قانون دوم، یک پیکان زمانی (Arrow of Time) معرفی کرد. گذشته و آینده از هم متمایز شدند. لیوان شکسته دوباره خودبهخود ترمیم نمیشود، نه به دلیل کمبود انرژی، بلکه به دلیل افزایش آنتروپی.

این قانون فقط دربارهٔ موتورهای بخار یا فرآیندهای صنعتی نیست. هر فرآیند طبیعی، از واکنشهای شیمیایی گرفته تا انتقال گرما، تابع همین گرایش است. گرما همیشه از جسم گرمتر به جسم سردتر منتقل میشود، مگر آنکه کاری خارجی انجام گیرد. این انتقال، نمونهای کلاسیک از افزایش آنتروپی است.

اهمیت این قانون در آن است که محدودیت ایجاد میکند. همهچیز ممکن نیست. حتی اگر قوانین دیگر اجازه دهند، آنتروپی مسیرها را فیلتر میکند. به همین دلیل، قانون دوم ترمودینامیک را گاهی بدبینانهترین قانون فیزیک نامیدهاند. اما در واقع، این قانون فقط واقعگرایانه است. نشان میدهد جهان چگونه کار میکند، نه اینکه چگونه باید باشد.

۳- آنتروپی آماری و پیوند آن با احتمال

وقتی فیزیکدانان به مقیاس اتمی و زیراتمی رسیدند، تعریف کلاسیک آنتروپی کافی نبود. در اینجا، فیزیک آماری وارد میدان شد. در این چارچوب، آنتروپی به زبان احتمال بازنویسی شد. هر حالت فیزیکی، مجموعهای از حالتهای ریزمقیاس دارد. هرچه این حالتها بیشتر باشند، سیستم محتملتر است.

لودویگ بولتزمن (Ludwig Boltzmann) نقشی کلیدی در این تحول داشت. او نشان داد که آنتروپی با لگاریتم تعداد حالتهای ممکن مرتبط است. این بیان ریاضی، مفهومی شهودی را تثبیت کرد. سیستمها به سمت حالتهایی میروند که راههای بیشتری برای تحقق دارند. این نه انتخاب آگاهانه است، نه قانون اخلاقی. صرفاً بازی احتمال است.

به زبان ساده، نظمِ خاص کمتر محتمل است. پراکندگی راههای بیشتری دارد. اگر چند سکه را پرتاب کنیم، همهشیر یا همهخط نتیجهای ممکن است، اما بسیار نادر. ترکیبهای درهمریخته بسیار محتملترند. آنتروپی دقیقاً این تفاوت را اندازه میگیرد.

این نگاه آماری باعث شد آنتروپی از یک مفهوم فیزیکی صرف فراتر رود. ایدهٔ احتمال، آن را به حوزههای دیگر قابل انتقال کرد. هرجا با تعداد حالتهای ممکن و توزیع آنها روبهرو هستیم، آنتروپی معنا پیدا میکند. این انعطاف مفهومی، راز ماندگاری آنتروپی در علم مدرن است.

۴- از انرژی تا معنا، چرا آنتروپی فقط یک کمیت فیزیکی نیست

با گسترش علم در قرن بیستم، آنتروپی وارد قلمروهای تازهای شد. در نظریهٔ اطلاعات (Information Theory)، کلود شنون (Claude Shannon) از آنتروپی برای سنجش عدم قطعیت استفاده کرد. اینبار، موضوع انرژی نبود، بلکه داده و معنا بود. هرچه پیام غیرقابلپیشبینیتر باشد، آنتروپی اطلاعاتی آن بیشتر است.

این انتقال مفهومی تصادفی نبود. هر دو نوع آنتروپی، بر پایهٔ احتمال بنا شدهاند. چه مولکولها را بشماریم، چه نمادها را، با توزیع حالتها سر و کار داریم. به همین دلیل، آنتروپی به زبان مشترک فیزیک، فناوری و ارتباطات تبدیل شد.

در زیستشناسی (Biology)، آنتروپی به شکل دیگری ظاهر میشود. موجودات زنده با مصرف انرژی، نظم موضعی ایجاد میکنند، اما در عوض آنتروپی محیط را افزایش میدهند. زندگی ضد آنتروپی نیست، بلکه با آن معامله میکند. این دیدگاه، نگاه سادهانگارانه به نظم زیستی را اصلاح میکند.

حتی در علوم انسانی، آنتروپی بهصورت استعاری به کار رفته است. فرسایش ساختارهای اجتماعی، از همگسیختگی معنا، یا پیچیدگی اطلاعاتی، همگی با الهام از همین مفهوم توصیف میشوند. آنتروپی، بیآنکه همهچیز را توضیح دهد، چارچوبی برای فهم جهت تغییر فراهم میکند.

۵- آنتروپی در سامانههای پیچیده و رفتار غیرخطی

وقتی از سامانههای پیچیده (Complex Systems) صحبت میکنیم، دیگر با مجموعهای ساده از اجزا طرف نیستیم. این سامانهها، مانند آبوهوا، شبکههای عصبی، اقتصاد یا حتی شهرها، رفتاری غیرخطی دارند. در چنین ساختارهایی، آنتروپی فقط سنجهٔ پراکندگی نیست، بلکه شاخصی از غیرقابلپیشبینیبودن نیز به شمار میآید. هرچه تعامل میان اجزا پیچیدهتر شود، تعداد حالتهای ممکن افزایش پیدا میکند و بهتبع آن، آنتروپی بالا میرود.

نکتهٔ مهم این است که افزایش آنتروپی در این سامانهها الزاماً به معنای فروپاشی نیست. گاهی افزایش آنتروپی زمینهساز پیدایش الگوهای تازه میشود. برای مثال، در سامانههای آشوبناک (Chaotic Systems)، بینظمی در مقیاس کوچک میتواند به الگوهای پایدار در مقیاس بزرگ منجر شود. این پدیده نشان میدهد که آنتروپی همیشه تخریبکننده نیست، بلکه میتواند بخشی از فرآیند زایش ساختار باشد.

در اینجا، آنتروپی به ابزاری تحلیلی تبدیل میشود. پژوهشگران از آن برای سنجش میزان پیچیدگی، میزان انعطافپذیری و حتی تابآوری سامانهها استفاده میکنند. سامانهای که آنتروپی بسیار پایین دارد، ممکن است بیشازحد شکننده باشد. در مقابل، آنتروپی بسیار بالا میتواند نشانهٔ ازهمگسیختگی کامل باشد. تعادل میان این دو، نقطهٔ حیات سامانه است.

این نگاه، درک ما از نظم را تغییر میدهد. نظم دیگر به معنای سکون نیست، بلکه حالتی پویا است که در مرز میان پیشبینیپذیری و بینظمی شکل میگیرد. آنتروپی، این مرز را قابل اندازهگیری میکند.

۶- آنتروپی و فناوری، از ماشین بخار تا عصر دیجیتال

تاریخ آنتروپی با تاریخ فناوری گره خورده است. نخستین کاربردهای این مفهوم در تحلیل ماشینهای بخار و بازده انرژی بود. مهندسان دریافتند که هیچ ماشینی نمیتواند تمام انرژی ورودی را به کار مفید تبدیل کند. بخشی از انرژی همواره به شکل گرما تلف میشود. این اتلاف، همان افزایش آنتروپی است.

با ورود به عصر دیجیتال، تصور میشد که آنتروپی اهمیت خود را از دست بدهد. اما واقعیت برعکس بود. در رایانش (Computing)، هر پردازش اطلاعاتی با مصرف انرژی همراه است. پاککردن یک بیت اطلاعات، حداقل مقدار مشخصی از انرژی را به گرما تبدیل میکند. این محدودیت، که به اصل لاندائر (Landauer’s Principle) معروف است، پیوند مستقیم میان اطلاعات و آنتروپی را نشان میدهد.

در مراکز داده، مدیریت آنتروپی به یکی از چالشهای اصلی تبدیل شده است. خنکسازی، توزیع بار پردازشی و بهینهسازی الگوریتمها، همگی تلاشی برای کنترل پیامدهای افزایش آنتروپی هستند. حتی پیشرفتهای هوش مصنوعی (Artificial Intelligence) نیز از این قاعده مستثنا نیستند. مدلهای بزرگتر، انرژی بیشتری مصرف میکنند و آنتروپی بیشتری تولید میشود.

این واقعیت، محدودیتی بنیادین برای فناوری ترسیم میکند. پیشرفت بینهایت بدون هزینه ممکن نیست. آنتروپی یادآور میشود که هر دستاورد فناورانه، بهایی فیزیکی دارد، حتی اگر این بها در ظاهر دیده نشود.

۷- آنتروپی در زیستشناسی، زندگی چگونه با بینظمی کنار میآید

در نگاه نخست، زندگی با آنتروپی در تضاد به نظر میرسد. موجودات زنده ساختارمند، منظم و هدفمند هستند. اما بررسی دقیقتر نشان میدهد که زندگی نه مخالف آنتروپی، بلکه همزیست با آن است. سلولها (Cells) با مصرف انرژی، نظم درونی خود را حفظ میکنند، اما در عوض آنتروپی محیط را افزایش میدهند.

متابولیسم (Metabolism) نمونهٔ روشنی از این فرآیند است. واکنشهای شیمیایی درون سلول، انرژی آزاد میکنند و گرما به محیط میدهند. این گرما، نشانهٔ افزایش آنتروپی است. بدون این تبادل، حیات ممکن نیست. زندگی، جزیرهای از نظم موقتی در دریای بینظمی است.

در تکامل زیستی (Biological Evolution)، آنتروپی نقشی غیرمستقیم اما تعیینکننده دارد. تنوع ژنتیکی، جهشها و انتخاب طبیعی، همگی با افزایش فضای حالتهای ممکن همراهاند. این تنوع، احتمال سازگاری را بالا میبرد. بهبیان دیگر، آنتروپی ژنتیکی، شرط لازم برای تکامل است.

این دیدگاه، تصور رمانتیک از زندگی را تعدیل میکند. حیات نه معجزهای خارج از قوانین فیزیک، بلکه پیامدی پیچیده از همان قوانینی است که بیجانترین سامانهها را نیز هدایت میکنند.

۸- آنتروپی و ذهن انسان، حافظه، فراموشی و عدم قطعیت

ذهن انسان نیز از منطق آنتروپی جدا نیست. حافظه، برخلاف تصور رایج، انبار اطلاعات ثابت نیست. با گذر زمان، جزئیات محو میشوند، ارتباطها تغییر میکنند و عدم قطعیت افزایش مییابد. این فرآیند را میتوان نوعی افزایش آنتروپی شناختی (Cognitive Entropy) دانست.

وقتی اطلاعات جدید وارد ذهن میشود، ساختارهای قبلی بازآرایی میشوند. این بازآرایی هزینه دارد. تمرکز ذهنی، انرژی مصرف میکند و خستگی ذهنی، نشانهٔ همین مصرف است. در نبود توجه فعال، ذهن به سمت حالتهای محتملتر میرود، یعنی سادهسازی، تعمیم و فراموشی.

در روانشناسی (Psychology)، برخی نظریهها از آنتروپی برای توضیح اضطراب استفاده میکنند. موقعیتهای مبهم، که پیشبینیپذیری پایینی دارند، آنتروپی ذهنی را افزایش میدهند و احساس ناامنی ایجاد میکنند. انسان بهطور طبیعی به دنبال کاهش این آنتروپی است، از راه معنا دادن، الگو ساختن یا تصمیمگیری.

این زاویهٔ نگاه نشان میدهد که آنتروپی فقط مفهومی فیزیکی نیست. ابزاری است برای فهم محدودیتهای شناختی و نیاز انسان به نظم معنایی.

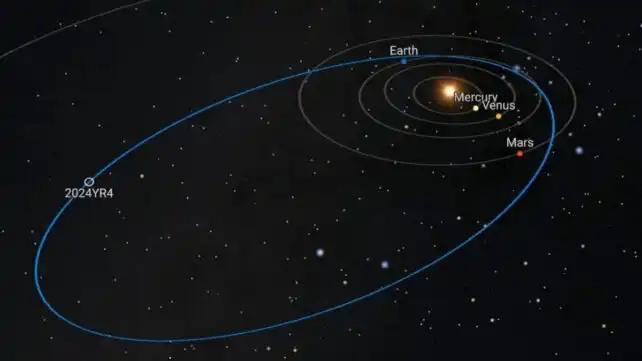

۹- آنتروپی و آیندهٔ جهان، از گرگومیش کیهانی تا مرگ گرمایی

در مقیاس کیهانی، آنتروپی تصویری گسترده و گاه نگرانکننده ترسیم میکند. کیهان از آغاز تاکنون در حال انبساط است و این انبساط با افزایش آنتروپی همراه بوده است. ستارگان میسوزند، انرژی آزاد میکنند و بهتدریج خاموش میشوند. این روند، برگشتناپذیر است.

یکی از سناریوهای مطرح دربارهٔ آیندهٔ جهان، مرگ گرمایی (Heat Death) است. در این حالت، تفاوتهای دما از بین میروند، انرژی قابل استفاده باقی نمیماند و آنتروپی به بیشینهٔ خود میرسد. جهان به حالتی یکنواخت و ایستا نزدیک میشود. نه انفجاری رخ میدهد، نه فروپاشی ناگهانی. فقط سکون.

البته این تنها سناریوی ممکن نیست. نظریههای جدید کیهانشناسی (Cosmology) گزینههای دیگری را نیز مطرح میکنند. اما در همهٔ آنها، آنتروپی نقشی محوری دارد. هر مدلی که جهت زمان را توضیح دهد، ناگزیر با آنتروپی روبهرو میشود.

این چشمانداز کیهانی، آنتروپی را از یک مفهوم فنی به پرسشی فلسفی نزدیک میکند. اگر پایان جهان چنین است، جایگاه معنا، آگاهی و کنش انسانی کجاست؟ پاسخ قطعی وجود ندارد، اما پرسش همچنان باقی است.

۱۰- آیا میتوان با آنتروپی مقابله کرد یا فقط آن را مدیریت کرد؟

پرسش رایج این است که آیا راهی برای شکست دادن آنتروپی وجود دارد. پاسخ علمی روشن است. نه. اما مدیریت آنتروپی ممکن است. تمدن انسانی دقیقاً بر پایهٔ همین مدیریت بنا شده است. ما با صرف انرژی، نظم موضعی ایجاد میکنیم، از خانهسازی گرفته تا ذخیرهسازی اطلاعات.

این مدیریت همیشه موقتی است. هیچ نظمی دائمی نیست. اما همین موقتیبودن، ارزش آن را کم نمیکند. برعکس، نشان میدهد که نظم نتیجهٔ کنش آگاهانه است، نه وضعیت پیشفرض جهان. آنتروپی، دشمن این نظم نیست، بلکه زمینهای است که در آن معنا پیدا میکند.

در نهایت، آنتروپی به ما فروتنی علمی میآموزد. یادآور میشود که جهان محدودیت دارد، منابع پایانپذیرند و هر انتخاب، پیامدی دارد. فهم این محدودیتها، شرط تصمیمگیری مسئولانه در علم، فناوری و زندگی است.

| حوزه | کارکرد آنتروپی | معنای بینظمی در این حوزه |

|---|---|---|

| فیزیک کلاسیک (Classical Physics) | سنجش پراکندگی انرژی | کاهش قابلیت انجام کار مفید |

| فیزیک آماری (Statistical Physics) | اندازهگیری تعداد حالتهای ممکن | افزایش احتمال حالتهای نامتمرکز |

| نظریه اطلاعات (Information Theory) | سنجش عدم قطعیت داده | پیشبینیناپذیری پیام |

| زیستشناسی (Biology) | تبادل نظم درونی با محیط | هزینهٔ حفظ ساختار حیات |

| ذهن و شناخت (Cognition) | مدلسازی فراموشی و ابهام | افزایش عدم قطعیت ذهنی |

| کیهانشناسی (Cosmology) | تعیین جهت زمان | حرکت جهان به سوی یکنواختی |

خلاصه نهایی

آنتروپی مفهومی است که از دل فیزیک زاده شد اما بهتدریج به زبانی مشترک برای فهم تغییر در جهان تبدیل شد. این مفهوم نشان میدهد که هر سامانهٔ طبیعی، از یک موتور ساده تا کل کیهان، گرایشی بنیادین به حرکت از حالتهای محدود به حالتهای محتملتر دارد. آنتروپی نه صرفاً بینظمی ظاهری، بلکه معیاری برای پراکندگی، عدم قطعیت و از دست رفتن قابلیت تمرکز است. قانون دوم ترمودینامیک، این گرایش را بهصورت یک قاعدهٔ غیرقابلنقض تثبیت میکند و جهت زمان را معنا میبخشد. در فیزیک آماری، آنتروپی به زبان احتمال بازتعریف میشود و نشان میدهد چرا نظمهای خاص ناپایدارند. در زیستشناسی و ذهن انسان، آنتروپی توضیح میدهد که چرا حفظ ساختار نیازمند مصرف مداوم انرژی است. در نهایت، آنتروپی به ما یادآوری میکند که نظم، استثنا است و دوام آن به آگاهی، کنش و مدیریت وابسته است نه به وضعیت پیشفرض جهان.

❓ سؤالات رایج (FAQ)

آنتروپی دقیقاً چیست و چرا با بینظمی یکی دانسته میشود؟

آنتروپی معیاری برای تعداد حالتهای ممکن یک سامانه است. چون حالتهای پراکنده معمولاً تعداد بیشتری دارند، آنتروپی اغلب با بینظمی تداعی میشود.

آیا افزایش آنتروپی همیشه به معنای تخریب است؟

خیر. در بسیاری از سامانههای پیچیده، افزایش آنتروپی میتواند زمینهساز شکلگیری الگوهای جدید و پویایی بیشتر باشد.

چرا قانون دوم ترمودینامیک اینقدر مهم است؟

این قانون جهت زمان را مشخص میکند و نشان میدهد چرا برخی فرآیندها برگشتناپذیرند، حتی اگر از نظر انرژی ممکن به نظر برسند.

آیا موجودات زنده با آنتروپی در تضادند؟

نه. حیات با مصرف انرژی، نظم درونی ایجاد میکند اما همزمان آنتروپی محیط را افزایش میدهد.

آنتروپی چه ارتباطی با اطلاعات دارد؟

در نظریه اطلاعات، آنتروپی میزان عدم قطعیت پیام را میسنجد و نشان میدهد داده تا چه حد قابل پیشبینی است.

آیا میتوان آنتروپی را متوقف کرد؟

در سطح کلی نه. اما میتوان با صرف انرژی، آنتروپی را بهطور موضعی مدیریت و نظم موقتی ایجاد کرد.

ارسال نقد و بررسی